首页 > AI视频 > 数字人

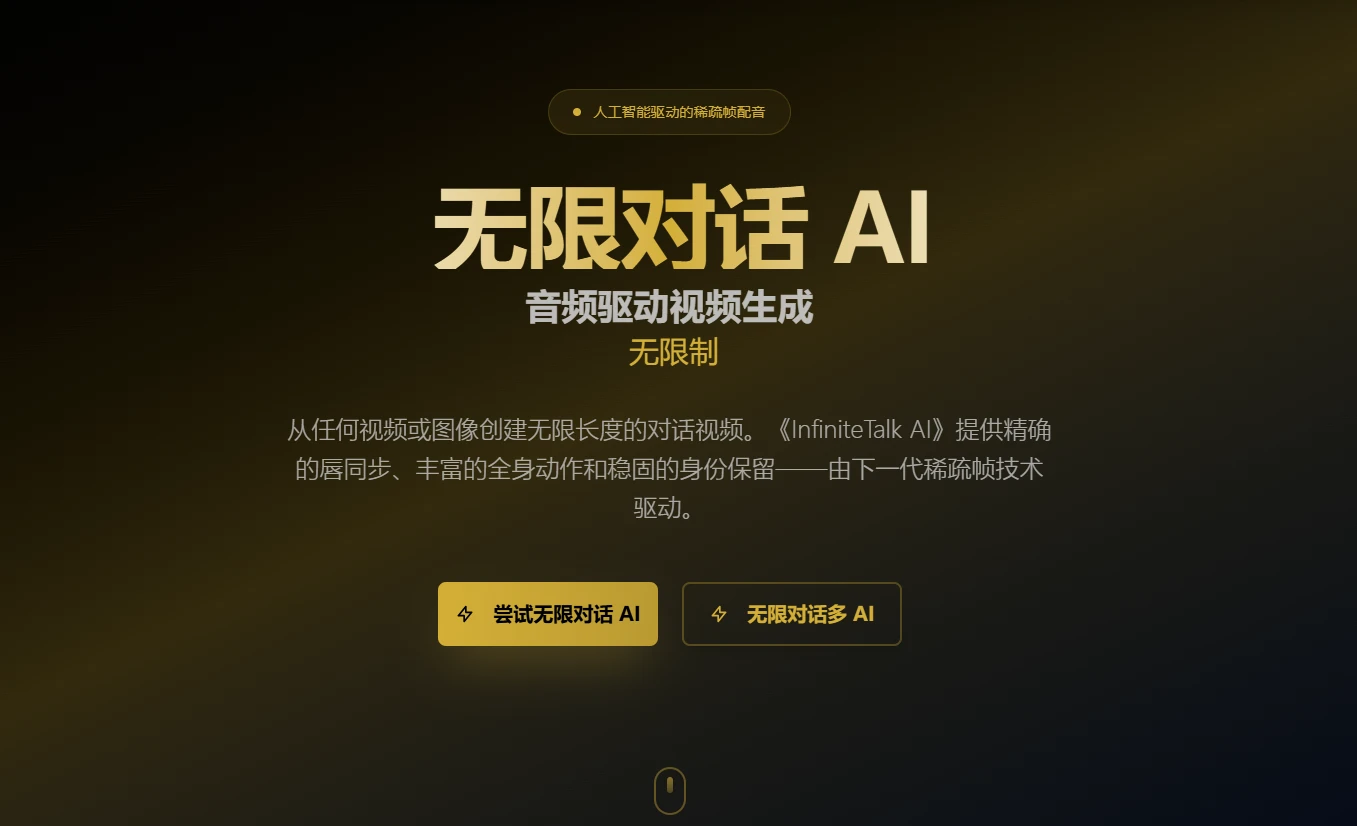

InfiniteTalk

InfiniteTalk是由美团视觉智能部研发的开源音频驱动视频生成系统,其核心突破在于将传统视频配音从单一的“口型同步”升级为“全身表达”的生成范式,实现自然流畅的音频驱动虚拟人合成。通过独创的稀疏帧视频配音技术(Sparse-Frame Video Dubbing),突破传统数字人视频的僵硬表现与时长限制,生成肢体动作、表情与唇形同步匹配的高质量视频内容。

标签: 音频驱动视频生成系统InfiniteTalk 是什么?

InfiniteTalk是由美团视觉智能部研发的开源音频驱动视频生成系统,其核心突破在于将传统视频配音从单一的“口型同步”升级为“全身表达”的生成范式,实现自然流畅的音频驱动虚拟人合成。通过独创的稀疏帧视频配音技术(Sparse-Frame Video Dubbing),突破传统数字人视频的僵硬表现与时长限制,生成肢体动作、表情与唇形同步匹配的高质量视频内容。

InfiniteTalk 的核心功能

1. 多模态动作同步

- 基于音频语义自动生成匹配的唇形、头部姿态、身体动作及表情(如疑问时歪头、激动时身体前倾)

- 超越传统“静态嘴型配音”,实现全身动态自然表达

2. 无限时长视频生成

- 分帧窗口技术(默认81帧/窗口)支持长视频连续性生成

- 影视级配音、直播推流等场景不受时长限制

3. 双输入模式兼容

- 视频重配音:保留原始画面动态,替换音频并同步口型

- 静态图激活:单张人物图片+音频即可生成“开口说话”的动态视频

4. 多人互动合成

- 支持双角色对话视频生成,通过分离蒙版技术智能匹配声源与人物动作

如何使用 InfiniteTalk

1. 环境部署

- 下载安装包:访问 GitHub仓库 获取Windows/MacOS客户端或直接访问InfiniteTalk官网

- 模型准备:下载Hugging Face或TheBloke提供的GGUF格式模型文件

2. 工作流配置

- 通过 ComfyUI-WanVideoWrapper插件 配置生成节点

- 设置帧窗口参数(帧数/重叠率)优化长视频效果

3. 内容生成

- 单人模式:上传音频+(视频/图片)→ 生成动态内容

- 双人模式:标记角色位置→上传双声道音频→生成互动视频

4. 开发者集成

- 调用兼容 OpenAI API规范 的本地接口

接入支持自定义后端的AI应用生态

InfiniteTalk 的核心优势

技术突破性

- 稀疏帧技术解决行业长视频连贯性难题

- 多模态动作同步提升真实感(官方测试显示唇形准确度提升>40%)

隐私与自主性

- 本地化运行保障数据零泄露

- 开源模型兼容(Llama 3/Phi-3/Gemma等)避免厂商绑定

应用自由度

- MIT开源协议支持商业场景无缝使用

- 社区共享上千种角色模板快速启用

成本可控性

- 本地计算节省云端推理费用

- 开放架构避免商业授权费用

InfiniteTalk 的适用场景

影视媒体制作

- 跨国影视作品本地化配音

- 历史人物“复活”解说纪录片

数字人直播

- 生成无限时长虚拟主播口播视频

- 双角色带货直播互动场景

教育创新

- 多角色情景教学视频生成

- 语言学习发音可视化辅助

开发者实验

- 快速验证语音驱动动画原型

- 构建私有化数字人解决方案

特别声明: AI资源导航站提供的InfiniteTalk 等网址链接均来源于InfiniteTalk 官网或用户投稿,该外部链接均指向官网。如果链接出现违规,请直接反馈或联系网站管理员进行删除处理。